Antes de emitir una opinión sobre el tema de la evaluación de la educación mexicana, sus consideraciones e interpretaciones es necesario considerar ciertos elementos de entrada.

Primero

Es irrenunciable e innegociable el derecho del Estado mexicano de evaluar todas y cada una de las acciones que son de su responsabilidad, sean de carácter económico, social, político, de seguridad, sustentabilidad o de cualquier otra índole que la Ley Orgánica de la Administración Pública Federal le confiera. Esto es una obligación y un derecho inalienable del Estado, nos guste o no. No es posible pensar en un Estado que no evalúe lo que hace, como tampoco es sano que una organización humana no evalúe lo que hace, para saber si va en el camino correcto o no, ante los objetivos que se plantea.

Segundo

La evaluación educativa no es un fin en sí misma, ni representa la fundación del sistema educativo mexicano, éste, deviene de muchas décadas atrás y está compuesto por diversas acumulaciones históricas, producto de varias generaciones de mexicanos y mexicanas. No se llegó al actual estado de cosas por arte de magia ni venimos de una situación mejor. Sólo por mencionar un dato, hace 100 años México tenía 80% de analfabetos y durante esos mismos 100 años hemos pasado de 15 millones de habitantes a 117 millones, esto es: 1 millón en promedio más por cada uno de estos 100 años y ahora sólo 7% ostenta esa lamentable condición. La evaluación educativa debe ser un mecanismo para mejorar la educación, y no como algunos esfuerzos evaluativos recientes, que se han trasformado en fines en sí mismos, olvidando el objetivo que pretendían (por ejemplo, se han acumulado más de 80 millones de las pruebas Evaluación Nacional del Logro Académico en Centros Escolares (ENLACE) y no existe evidencia de haber avanzado en algo, dato mencionado también por José Ángel Pescador en declaraciones al periódico Reforma (11-jun-2012).

Tercero

Dentro de las acumulaciones históricas que componen el actual Sistema Educativo Mexicano están los legítimos derechos adquiridos de los trabajadores de la educación, nótese que escribo legítimos con cursivas, esto en función de que dichos derechos son los que responden unívocamente a las legítimas obligaciones que los trabajadores de la educación se comprometen a partir de su nombramiento. La Evaluación Educativa y de los Docentes debe reconocer irrestrictamente estos legítimos derechos, siempre y cuando se cumplan con las legítimas obligaciones contractuales que les vinculan.

Dicho desde otra perspectiva, el hecho educativo, aun cuando responde al ejercicio de un derecho humano (El derecho a la Educación, artículo 26 de la Declaración Universal de los Derechos Humanos), también está delimitado por la confluencia de otro derecho humano, definido en el artículo 23 de la misma Declaración, el derecho al trabajo.

En la confluencia de estos dos derechos humanos —a la educación y al trabajo— deben determinarse los alcances y limitaciones de la evaluación educativa y, por ende, la de los docentes.

Cuarto

Las terribles condiciones de inequidad social y económica que caracterizan a nuestro país hacen que el entorno y los medios en que se da el hecho educativo también se vean arrastrados a estas condiciones en las que no necesariamente se observan los apoyos y las retribuciones que compensen dichas condiciones en contextos menos favorecidos. Todo lo contrario, a entornos de mayor pobreza y rezago social corresponden condiciones educativas más precarias y limitadas, por lo que la evaluación educativa y la de los docentes deberá observar dichas inequidades.

Quinto

Quinto

Concomitante con el anterior elemento (condiciones del entorno y medios educativos), está lo que podríamos llamar “la materia prima”: los alumnos mismos. Según la investigación educativa dura de todo el planeta (incluyendo el Programa Internacional para la Evaluación de Estudiantes, PISA; el Estudio de las Tendencias en Matemáticas y Ciencias, TIMSS, y el Laboratorio Latinoamericano de Evaluación de la Calidad de la Educación, LLECE), generalmente la variable que más gravita en los resultados del aprendizaje en países de alta diferenciación sociocultural o inequidad como el nuestro es el capital cultural de entrada de los alumnos, cuyo mayor “predictor” es el grado máximo promedio de educación de sus padres, por lo que no aislar el efecto del capital cultural de los alumnos en los resultados de ENLACE, generalmente será una forma de estigmatizar a los alumnos menos favorecidos y sobredimensionar a los más beneficiados; de profundizar las inequidades sociales existentes; y, resultará del todo injusto para los docentes, pues los resultados de alumnos con bajo capital cultural serán usualmente más bajos en comparación con los docentes cuyos alumnos tengan un capital cultural alto.

Lo expuesto en los puntos anteriores no se resuelve por decreto o con reformas educativas cupulares, por más inteligentes y bien intencionadas que sean; se resuelve con apertura, debate, reflexión social, pero sobre todo, con honestidad y verdad. Si la autoridad no hace gala de estas cualidades, no se abre a sustentar sus modelos y sí asume una posición de poseedor de la verdad absoluta, sin aceptar la participación y el debate de altura, el proyecto de evaluación provocará desconfianzas y rechazos. Es necesario un proceso de verificación social del desarrollo evaluativo y, con mayor razón, de legitimación por parte de la comunidad educativa.

Por otra parte, para neutralizar las distorsiones de los factores externos y de contexto en las evaluaciones educativas, técnicamente no basta con imputar a las escuelas el índice de marginalidad de las localidades elaborado por el Instituto Nacional de Estadística Geografía e Informática (INEGI), ya que ni los planteles tienen condiciones consistentes con dicho índice, ni los alumnos que asisten a ellas pertenecen necesariamente al entorno donde ésta se ubica, sólo baste ejemplificar con las escuelas públicas que se hallan en barrios de alto ingreso, cuyos alumnos generalmente no pertenecen a dicho entorno, sino que habitualmente son hijos de los trabajadores de tales zonas.

Tampoco se resuelven estas distorsiones con las pretendidas “comparaciones entre iguales” que en algún momento propuso la sep, presentar los resultados separados por control (privadas con privadas, públicas con públicas) o por modalidad (secundarias generales con generales, técnicas con técnicas, telesecundarias con telesecundarias, indígenas con indígenas, etcétera), ya que esto tendería a ahondar aún más la inequidad y soslayarla, como también a “maquillar” la obligación del Estado mexicano de garantizar una misma calidad educativa en cada nivel educativo, sin importar controles o modalidades.

Se requiere la construcción del Índice de Esfuerzo Escolar (IEE),1 que considere para cada alumno, el entorno y su capital cultural de entrada. Índice que no representa una complicación técnica importante, pero que lastimosamente en el pasado la Secretaría de Educación Pública (SEP) o el Instituto Nacional de Evaluación Educativa (INEE) —responsables de las evaluaciones educativas— han asumido una actitud poco creadora o “temerosa” para proponer innovaciones propias y han preferido copiar lo que los países del “norte” hacen —naciones cuyas realidades y necesidades nada tienen que ver con las nuestras—, u optan por sólo usar los resultados brutos.

Llegados a este punto, conviene hacer una acotación al respecto de las críticas a las evaluaciones educativas. Si bien es importante considerar las condiciones en que se da el hecho educativo y las diferencias de entrada de los alumnos en las evaluaciones educativas, a efectos de no comparar “peras con manzanas”, también es cierto que a partir de esta consideración se cuestiona la evaluación con argumentos del todo equivocados, simplistas e invalidantes de todo esfuerzo evaluativo. A partir de lo anterior se hace necesario salir al paso, para aclarar algunos puntos.

Llegados a este punto, conviene hacer una acotación al respecto de las críticas a las evaluaciones educativas. Si bien es importante considerar las condiciones en que se da el hecho educativo y las diferencias de entrada de los alumnos en las evaluaciones educativas, a efectos de no comparar “peras con manzanas”, también es cierto que a partir de esta consideración se cuestiona la evaluación con argumentos del todo equivocados, simplistas e invalidantes de todo esfuerzo evaluativo. A partir de lo anterior se hace necesario salir al paso, para aclarar algunos puntos.

La medición de los aprendizajes es a la educación lo que el metro es a la longitud. Es un instrumento de medida y sólo eso. Con esto quiero decir —ejemplificando— que no importa que uno sea de estatura baja o muy alto para que sea legítimo usar el mismo metro para medirnos. Pensar que por tener menos de 1,50 metros de estatura debe usarse un metro distinto al que mida la altura de una persona que mida más de 2 metros es totalmente absurdo, no resiste el menor análisis y no es un argumento serio. El metro es uno y único para medir la dimensión denominada longitud, no importa si se es pequeño o grande.

Este argumento es igualmente válido para medir los rendimientos educativos. Es totalmente absurdo lo que proponen algunos pseudoexpertos en educación, como utilizar instrumentos distintos para evaluar una misma competencia, por el hecho de que las condiciones en que se da la acción educativa sea distinta o que los alumnos provengan de diferentes entornos. Hay que instrumentar procedimientos estadísticos básicos, que permitan aislar el efecto del contexto y rescatar el verdadero esfuerzo escolar o el valor agregado que la acción educativa y el alumno aporten. Lo anterior no se desdice cuando hablamos de comunidades que hablan distintas lenguas, de la misma forma que a nivel internacional, las competencias a evaluar en pisa son las mismas en todos los países, aunque varíe el idioma en que se expresan los instrumentos.

El problema no es el metro o instrumentos que se usen para medir, son los factores que se incluyen en la ecuación, la forma de interpretar las mediciones y cómo son presentados los resultados.

Para mejorar lo anterior, la propuesta es muy simple. La prueba ENLACE debería al menos:

- Incorporar a la medición de los aprendizajes la ponderación de las distintas condiciones en que se da el hecho educativo en cada escuela, misma que puede rescatarse del formato 911 (o estadística educativa de inicio y fin de cursos);

- Acompañar el instrumento de medición con entre dos a cinco preguntas adicionales, relativas a la educación de los padres de los alumnos o sobre las condiciones del hogar;

- Medir el efecto de las distinciones recolectadas en los dos puntos anteriores en los resultados de la prueba ENLACE;

- Descontar del puntaje bruto obtenido a nivel individual, el efecto citado en el punto anterior, y así reconocer el IEE.

Un ejemplo de lo anterior lo he planteado en varios libros y publicaciones con respecto a los resultados de PISA y ahora lo vuelvo a presentar aquí —que no por repetido, pierde un ápice de validez y oportunidad—, para ejemplificar cómo pueden leerse de una manera más justa, objetiva y realista sus resultados, sin renunciar a los datos brutos que también son útiles para la toma de decisiones.

Se requiere la construcción del Índice de Esfuerzo Escolar (IEE), que considere para cada alumno, el entorno y su capital cultural de entrada.

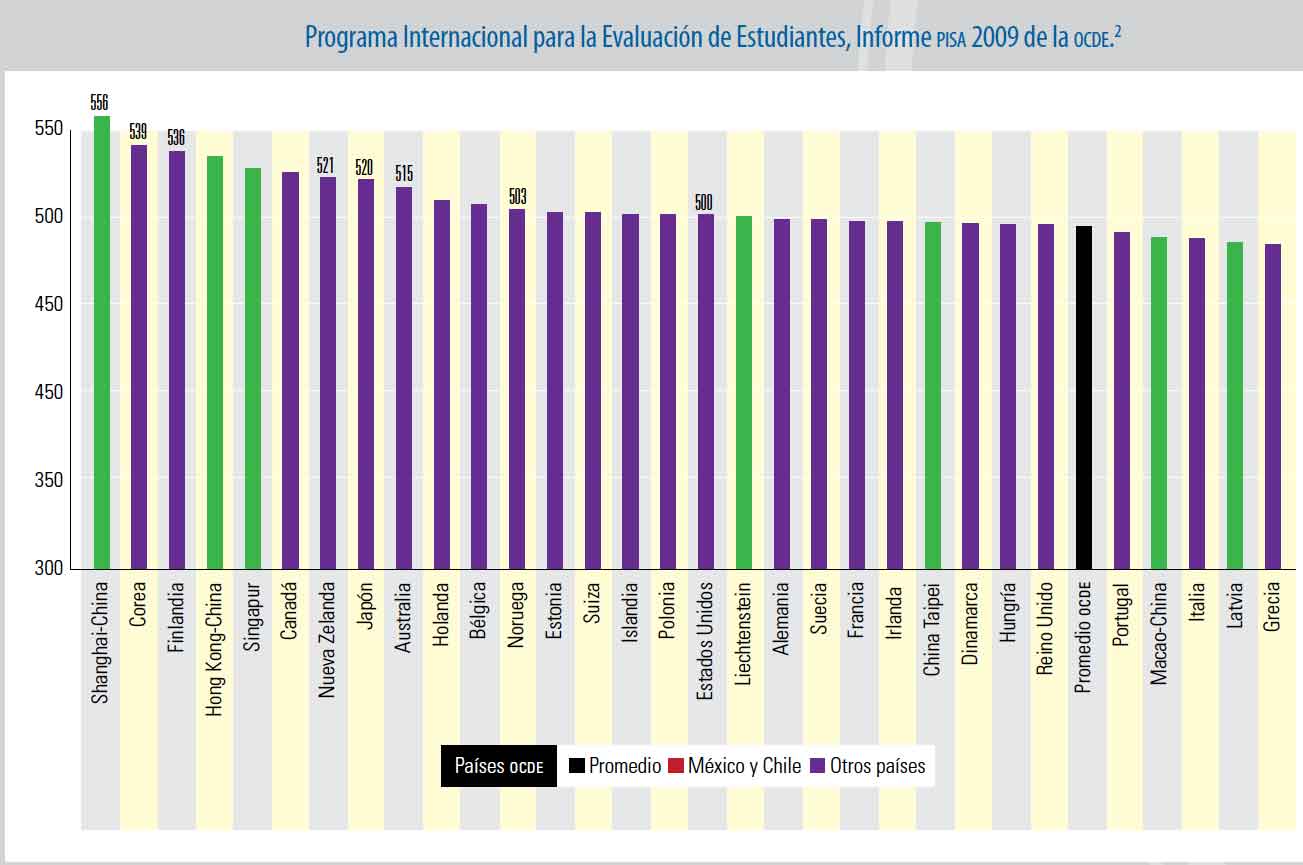

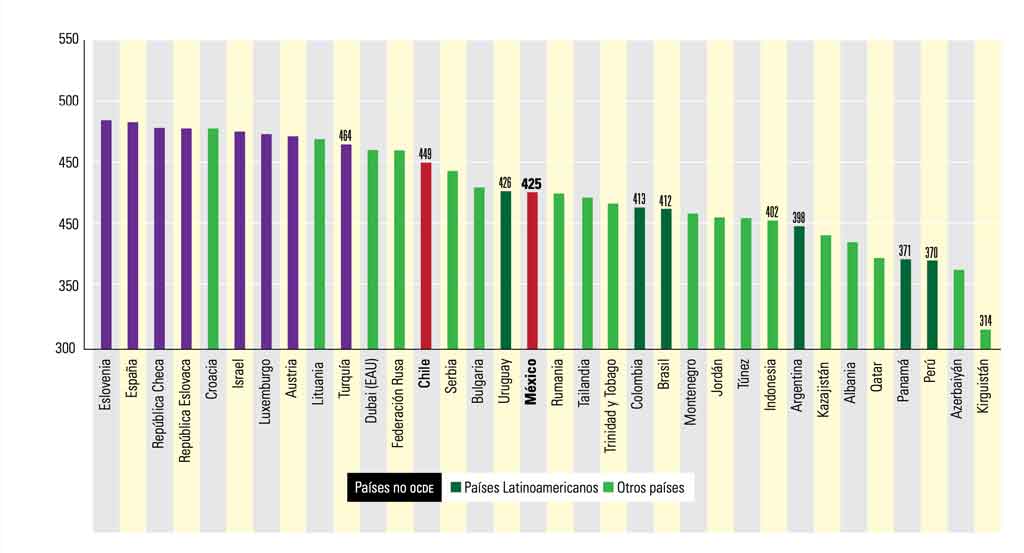

En este ranking, México se ubica en el último lugar de los países miembros de la Organización para la Cooperación y el Desarrollo Económicos (OCDE), lo que confirma lo concluido en otras investigaciones, en tanto que si México se compara con los países de alto desarrollo, se encontrará generalmente en las últimas posiciones, mientras que cuando se incluyen países con desarrollos medios o bajos, su posición mejora de forma significativa, ubicándose en el tercer cuarto de la distribución total de PISA, incorporándose Uruguay por encima de México, y 17 países —dentro de los cuales quedan Colombia, Brasil, Argentina, Panamá y Perú— por debajo.

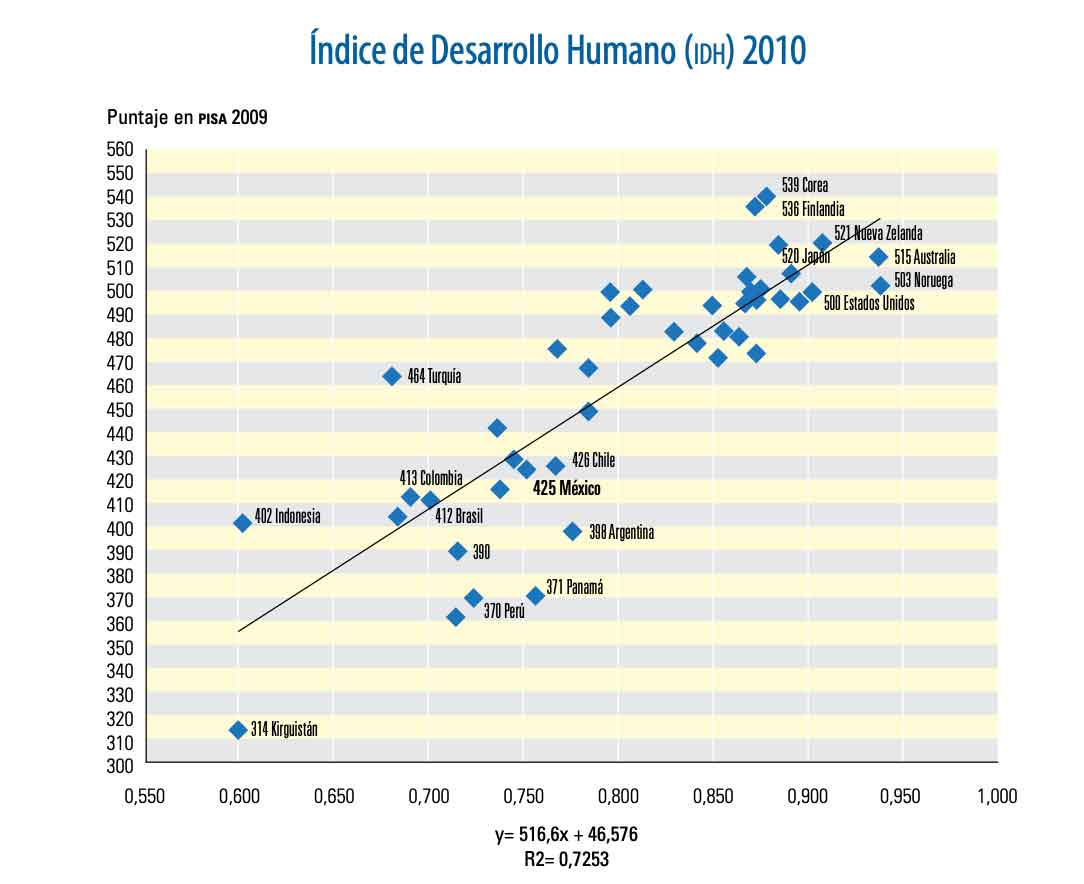

La mayoría de investigaciones “duras” en el mundo han demostrado que en países de alta diferenciación o inequidad social, gran parte de la variación de los puntajes se debe a las condiciones del contexto de los alumnos y posteriormente a lo que sucede en el aula, por lo que conviene analizar los resultados de PISA a la luz de algún indicador que dé cuenta de dicho contexto. Más adelante se presenta una correlación, una interpretación y un nuevo ordenamiento de los países en función del Índice de Desarrollo Humano (IDH), mostrando sólo los países que cuentan con dicho índice para 2010 y destacando en el gráfico la ubicación específica de los de mayor y menor promedio, así como los latinoamericanos.

Se observa una alta correlación entre las dos variables (0,7253), lo cual da cuenta de que el desempeño escolar es un fenómeno fundamentalmente estructural, cultural, que está íntimamente relacionado con otras variables del desarrollo. La educación no es un hecho aislado, no necesariamente puede ser explicado en sí mismo, sino en su contexto. A cierto nivel de IDH, es previsible determinado puntaje en investigaciones de naturaleza similar a PISA o ENLACE, por lo que conviene hacer un análisis de cuánto está por arriba o por debajo del puntaje previsible dado el IDH de cada país, estado, municipio, sector, zona escolar, escuela, grupo o alumno, con lo cual estaremos más cerca de una evaluación más justa y realista del esfuerzo (IEE), en función de su propio nivel de desarrollo. Así, tenemos el siguiente nuevo ordenamiento (incluye los países que cuentan con IDH en 2010 y que participaron en PISA 2009):

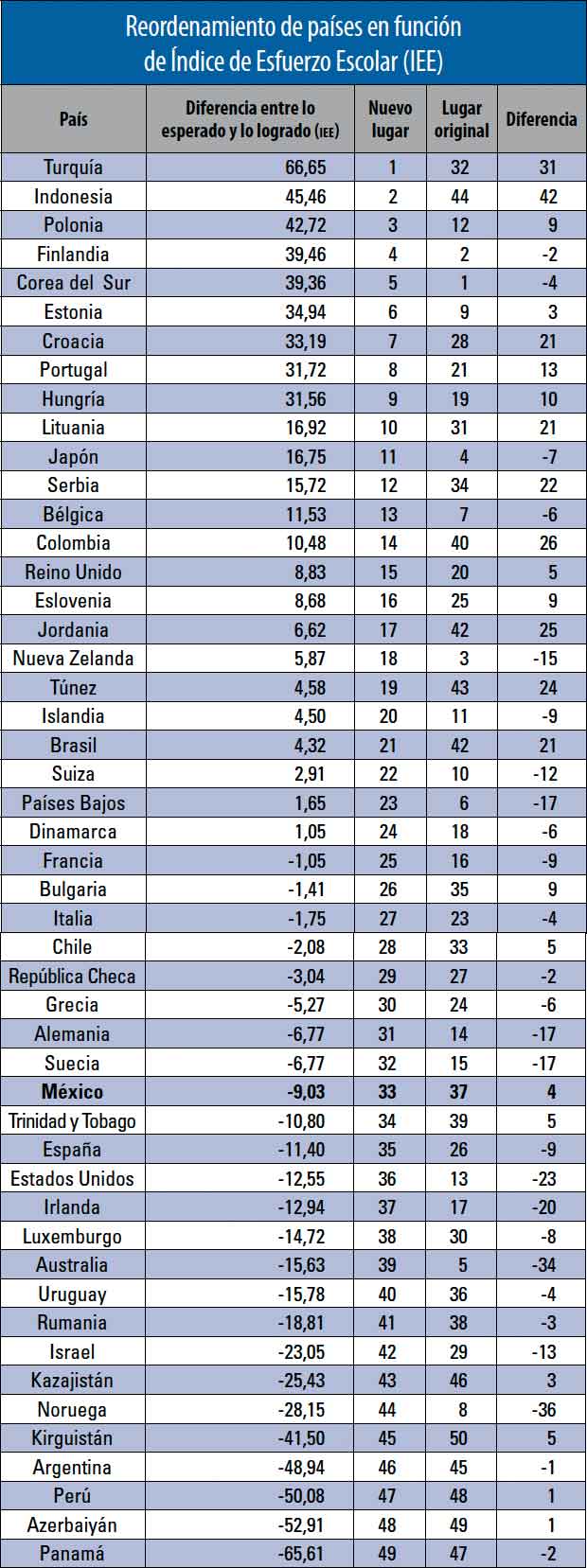

Reordenamiento de países en función del IEE

De la anterior tabla se puede deducir que el solo ranking que aporta PISA inicialmente puede ser interpretado de una forma más constructiva, en la cual se reconozca el verdadero esfuerzo escolar, mismo que indica lo que cada país aporta, o no, en función de su desarrollo humano concomitante a la aplicación de la prueba pisa3 (IEE).

Del nuevo ordenamiento se distinguen dos tipos de países. Uno, compuesto por aquellos cuyo rendimiento es superior al esperado (IEE > 0), y el otro, con aquellos en los que es inferior al esperado (IEE < 0). Se observa. entre otras cosas, que Corea del Sur, Finlandia y Nueva Zelanda, originalmente 1º, 2º y 3er lugar, pasan a ser el 5º, 4º y 18 en la nueva clasificación por IEE, mientras que Turquía, que en el ranking original ocupaba el lugar 32, pasa al primer lugar del nuevo ordenamiento por IEE, seguido por Indonesia, inicialmente en el lugar 44 y de Polonia, ubicado en el lugar 12.

En cuanto a los países latinoamericanos, también cambian sus posiciones. Mientras que Uruguay y Argentina bajan su ranking del 36 al 40 y del 45 al 46 respectivamente, México mejora del 37 al 33, Chile sube del 33 al 28, Brasil del 42 al 21 y Colombia del 40 al 14, con mucho el mejor país latinoamericano en función del IEE.

México, que tiene un IEE de -9,03, o sea 9,03 puntos en la escala de PISA por debajo de lo esperado dado su IDH, además de mejorar su posición relativa en el ranking inicial de PISA 2009, se ubica por encima de países de la OCDE como España, Estados Unidos, Irlanda, Luxemburgo, Australia y Noruega, inicialmente colocados en mejor posición, así como de Uruguay.

Con este ejemplo, lo que se busca es poner en el centro del debate que los rankings de cifras “llanas”, sin contextualizar, son útiles pero no suficientes e inducen a falsas apreciaciones y equívocos en los juicios de valor acerca de la calidad educativa que pretenden definir, ya que no es lo mismo los mayores puntajes, que los mejores puntajes, hecho aparentemente ininteligible para los detractores de la educación mexicana tan en boga hoy día.

Cuando el análisis se hace entre poblaciones iguales en cuanto a su nivel socio-cultural, el orden cambia sustantivamente. Error de apreciación que desgraciadamente se da desde el ámbito de las naciones, hasta el microcosmos de la comparación entre estados, escuelas, salones de clases y de los alumnos mismos, al compararlos únicamente por los puntajes llanos sin contextualizar, lo que lleva a considerar que algunas modalidades, tipos o localizaciones educativas sean mejores que otras per se (por ejemplo: secundarias generales en contraposición de las telesecundarias, escuelas privadas en comparación con escuelas públicas, urbanas con relación a las rurales o indígenas, etcétera), cuando en la realidad lo que sucede es que están en contextos distintos y atienden a poblaciones con diferentes capitales culturales.

En síntesis, la evaluación educativa es necesaria, quizá indispensable, pero de ninguna manera es justificable tratar de hacernos un “traje a la medida” para ocultar debilidades, como tampoco lo es hacer juicios de valor a partir de contextos distintos. Hay que hacer un uso más inteligente de las herramientas y avances que la técnica de la evaluación nos procura para arribar a conclusiones válidas que lleven a decisiones lo más racionales posibles, en beneficio de la educación mexicana y de su mejora.

Notas:

1 Índice propuesto por el autor de este artículo en distintos textos.

2 Escala de lectura en general, “Results: Executive Summary” The OECD Programme For International Student Assessment (PISA), http://www.oecd.org/pisa/ pisaproducts/46619703.pdf, p. 9.

3 Es importante destacar que México es el país de la ocde con mayor porcentaje de estudiantes cuyo índice de entorno económico, social y cultural es menor que -1, con 58,2%, seguido por Turquía (58,0%) y Chile (37,2%). pisa 2009 Mensajes Clave para México, http://www.oecd.org/ dataoecd/55/9/46640394.pdf.